Откуда ИИ знает то, что никто ему не говорил

Редактор журнала Scientific American Джордж Массер — о том, почему модели ИИ, обученные повторять, как попугаи, тексты из интернета, оказываются способны решать совершенно новые для них и весьма продвинутые задачи.

Никто не может сейчас сказать, как изменится мир с распространением ChatGPT и других чат-ботов на основе искусственного интеллекта, поскольку никто на самом деле не знает, что происходит у них внутри. Возможности подобных систем выходят далеко за рамки того, чему их обучали, и даже их разработчики не могут понять, почему. Все большее число тестов показывает, что системы искусственного интеллекта создают внутри себя модели реального мира так же, как это делает человеческий мозг, только технология у машин иная.

«Все наши попытки усовершенствовать их, сделать безопаснее и тому подобное кажутся мне смешными. Что мы можем сделать, если мы не понимаем, как они работают?» — говорит Элли Павлик из Университета Брауна. Она принадлежит к числу тех исследователей, которые пытаются восполнить этот недостаток знания.

До определенной степени она с коллегами понимает принцип работы и GPT (generative pre-trained transformer, генеративный предварительно обученный трансформер), и других LLM (Large Language Models, большие языковые модели). Эти модели основаны на системе машинного обучения, называемой нейронной сетью. Такие сети имеют структуру, организованную по образцу связанных между собой нейронов человеческого мозга. Код этих программ относительно прост и занимает всего несколько экранов. Он устанавливает алгоритм автокоррекции, который выбирает самое подходящее слово для завершения некоторой фразы на основе кропотливого статистического анализа сотен гигабайт интернет-текстов.

Дополнительное обучение позволяет системе представлять результаты в форме диалога. В этом смысле все, что она делает, — извергает то, что в нее заложили. Это «стохастический попугай», по выражению Эмили Бендер, лингвиста из Вашингтонского университета. Но при этом LLM удалось сдать экзамен на адвоката, написать сонет о бозоне Хиггса, признаться в любви одному из своих собеседников и даже попытаться принудить его к разводу. Мало кто ожидал, что простой алгоритм автокоррекции обретет такие разносторонние способности.

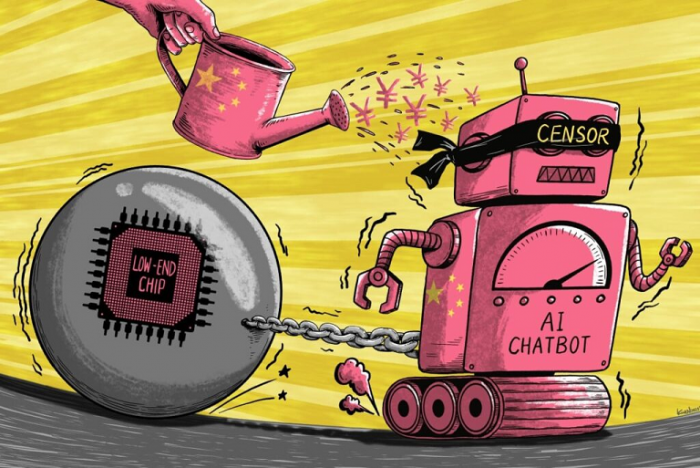

Пока основные компании-разработчики, преуспевшие с чатботами, находятся в США. Считается, что в Китае им мешают ограничения как со стороны цензуры, так и технического характера / © Wikimedia Commons

Пока основные компании-разработчики, преуспевшие с чатботами, находятся в США. Считается, что в Китае им мешают ограничения как со стороны цензуры, так и технического характера / © Wikimedia Commons

Тот факт, что GPT и другие системы искусственного интеллекта выполняют задачи, к которым их не готовили, проявляя свои «новоприобретенные способности», впечатлил даже тех исследователей, которые прежде не разделяли восторгов по поводу LLM.

«Я не знаю, как это у них получается, и насколько их способ действий похож на человеческий, но они заставили меня пересмотреть мои взгляды», — говорит Мелани Митчелл, эксперт по ИИ из Института Санта-Фе.

«Это, конечно, нечто большее, чем стохастический попугай, и он, конечно, создает внутри себя некоторое представление о мире — но я не думаю, что это похоже на то, как это делают люди», — говорит Йошуа Бенджио, исследователь ИИ в Монреальском университете.

На конференции в Нью-Йорке в этом году философ из Колумбийского университета Рафаэль Мильер привел еще один поразительный пример того, на что способны LLM.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России