Стоит ли опасаться совершенствования искусственного интеллекта?

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

В последнее время стало модно опасаться, что высокоразвитый искусственный интеллект когда-нибудь восстанет против людей. Или ещё как-нибудь навредит. Мировые СМИ регулярно публикуют подобные прогнозы, и подобные мысли высказали некоторые известные бизнесмены, учёные и IT-специалисты. Но существует и иной ― оптимистичный ― взгляд на будущую роль технологий ИИ.

Голоса пессимистов сегодня всё громче, и к их лагерю примыкают всё новые «агенты влияния», люди и целые компании, к чьему мнению прислушиваются всё более широкие слои населения. Скажем, вот совсем свежий пример от The Guardian:

Этот ролик отражает опасения, уже циркулирующие в обществе, при этом ещё более укрепляя их. До недавнего времени считалось, что многие интеллектуальные профессии, связанные с созданием чего-то нового, не будут подвержены автоматизации по той простой причине, что невозможно в обозримом будущем создать достаточно продвинутый искусственный интеллект. Тем не менее, недавно проведённый опрос показал, что около трети разработчиков ПО на Западе всерьёз опасаются того, что их место займут машины. Эти страхи подпитываются и академической средой. Например, в 2013 году Оксфордский университет опубликовал исследование «Будущее рынка труда», в котором высказано предупреждение о скорой замене автоматизации сферы разработки ПО.

Неудивительно, что на этом фоне многие из нас предпочтут, чтобы технологии ИИ не развивались. Зачем взращивать то, что в скором времени может лишить тебя работы?

Однако немало людей придерживаются иного взгляда на этот вопрос. Искусственный интеллект ― одна из важнейших IT-технологий, получивших развитие за последнее десятилетие. И для нас ИИ не угроза, а инструмент с замечательными возможностями. Грубо говоря, ИИ можно охарактеризовать как способность компьютера понимать вопросы человека, искать информацию в базах данных и формулировать точные и понятные ответы. Также ИИ ― это способность компьютера обрабатывать огромные массивы данных, принимать решения и предпринимать (или советовать предпринять) определённые действия.

Всем известны такие примеры ИИ, как Siri, Cortana и IBM Watson. Последний представляет собой систему, состоящую из суперкомпьютера и специального программного обеспечения. Watson одержал победу в игре Jeopardy («Своя игра»), а также используется для обработки больших объёмов медицинских данных при лечении онкологических заболеваний.

Система AlphaGo, разработанная Google DeepMind, обыграла в игру го Ли Седоля, обладателя девятого профессионального дана, одного из лучших мастеров го в мире. Ранее считалось, что выиграть в го компьютеры не смогут еще десятилетие.

Но всё это лишь первые шаги на пути к действительно мощному искусственному интеллекту, что-то вроде J.A.R.V.I.S. из фильма «Железный человек».

Какие возможности даст нам ИИ?

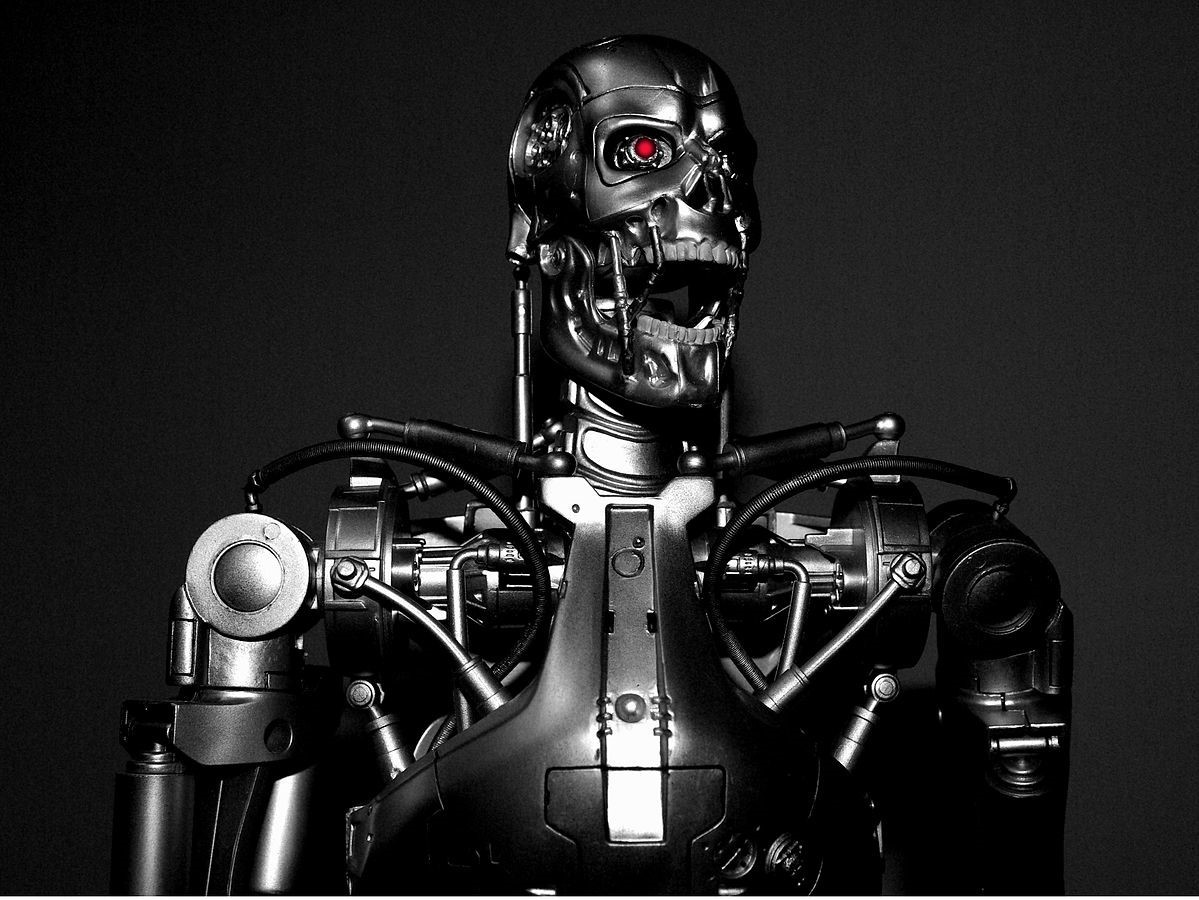

Терминатор – один из самых известных примеров применения ИИ (на данный момент только в кинематографе).

В первую очередь ― равные возможности в ряде сфер деятельности. Сегодня поисковый движок Google обеспечивает равный доступ к мировой информационной среде, где бы вы не жили. А будущие системы искусственного интеллекта уравняют возможности людей с точки зрения пользования всевозможными сервисами и услугами, от здравоохранения до советов по вложению финансовых средств. Ну, или как минимум уменьшат разрыв в подобных возможностях для жителей разных стран.

ИИ займут место в точных науках, финансировании, обучении, дизайне, приготовлении пищи, развлечениях и множестве других сфер деятельности. Стоимость «труда» ИИ будет крайне низкой, поэтому мы сможем пользоваться им бесплатно или очень дёшево. Иными словами, широкое внедрение продвинутых технологий искусственного интеллекта сделает многократно доступнее самые разные услуги, что позволит улучшить качество жизни всё быстрее растущего населения планеты. Быть может, приближая нас ко всеобщему изобилию.

(Почти) нет причин для страхов

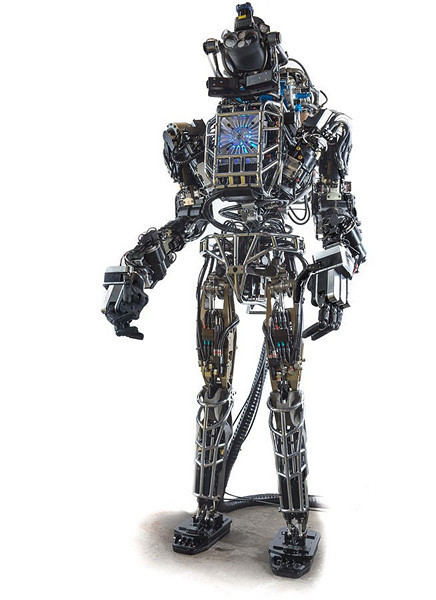

Роботы – одно из возможных воплощений ИИ. Вовсе не обязательно, что мы будем общаться с ИИ через подобные механизмы. Возможно, что роботы останутся всего лишь бессловесными помощниками, в то время как ИИ возьмут на себя решение алгоритмических задач.

Роботы – одно из возможных воплощений ИИ. Вовсе не обязательно, что мы будем общаться с ИИ через подобные механизмы. Возможно, что роботы останутся всего лишь бессловесными помощниками, в то время как ИИ возьмут на себя решение алгоритмических задач.

Людям свойственно преувеличивать и давать волю эмоциям. Особенно по отношению к новым технологиям. К тому же миллионы лет эволюции ― то есть выживания ― наделили нас таким свойством, как боязнь всего непонятного. Кто его знает, чего можно ожидать от этого вашего «умного» компьютера… А Голливуд и журналисты активно поддерживают наши страхи перед будущим.

В 1980-х годах учёные открыли рестриктазы ДНК, что открыло дорогу генной инженерии. И мировые СМИ начали массово пугать всех ужасными вирусами, выведенными в лабораториях, и всевозможными мутантами. Вместо этого мы получили более эффективные лекарства и выросшую производительность сельского хозяйства. Что примечательно, регулирование в сфере генной инженерии было налажено по инициативе учёных и врачей, а не чиновников. В 1975 году была созвана так называемая Асиломарская конференция, в ходе которой профессиональным сообществом были выработаны принципы и рекомендации, которые по сей день помогают развивать генную инженерию и удерживать её в этических рамках.

А вспомните, какая истерия возникла в СМИ после клонирования овечки Долли в 1996. Нам обещали скорое появление армий клонированных солдат, массовое выведение гениев и целые фермы специально выведенных доноров органов. И где это всё?

Предотвращение угроз

Так выглядят страшные сны всех противников создания ИИ.

Так выглядят страшные сны всех противников создания ИИ.

Конечно, сильный ИИ, думающий не хуже человека, ― это совсем не то же самое, что современные виртуальные помощники и голосовые поисковые движки. Помимо захватывающих дух возможностей, мы получим и определённые риски, и угрозы. Любая радикально новая технология всегда устрашает. Стивен Хокинг назвал искусственный интеллект величайшей ошибкой человечества. Билл Гейтс признался, что «через несколько десятилетий искусственный интеллект станет достаточно развитым, чтобы стать причиной для беспокойства». Глава высокотехнологичных компаний Tesla Motors и SpaceX Элон Маск высказалсяоб ИИ не иначе как о «главной экзистенциальной угрозе».

Однако сам Элон Маск тут же решился лично вложиться в компанию, занимающуюся разработкой ИИ, по всей вероятности, руководствуясь принципом «не можешь победить врага – возглавь его». Идею предпринимателя поддержали сооснователь PayPal Питер Тиль и глава Y Combinator Сэм Альтман, профинансировав некоммерческую организацию OpenAI, созданную для контроля разработки ИИ.

Никто не знает точно, достаточно ли существующих на сегодняшний день технологий для появления полноценного ИИ или нужно ждать еще десятки лет, пока не появятся новые вычислительные мощности. Однако предположим, что известные нам технологии – это именно то, что нужно для ИИ. Первыми в создании искусственного интеллекта будут заинтересованы военные (например, DARPA). Даже если вы создадите дружественный ИИ, никто не помешает какому-то государству довериться «ястребам войны» и создать ИИ враждебный.

Будущий ИИ должен понимать абсолютную ценность человеческой жизни. А до появления разумных машин ценность эту должны понимать создатели – сами люди, ответственные за развитие необходимых технологий. Представители OpenAI считают, что миру прямо сейчас нужен ведущий исследовательский институт, который не подчинялся бы одному правительству или определенной коммерческой корпорации, и чьи научные изыскания были бы доступны всему научному сообществу по принципу open source.

OpenAI, которую возглавил Илья Суцкевер, один из самых известных в мире специалистов по машинному обучению, стремится к тому, чтобы ИИ не оказался в руках какой-то определенной группы лиц, преследующих свои цели. Решение в области обеспечения безопасности суперинтеллекта кроется в исключении опасных программных закладок, возможных (даже по ошибке) на стадии создания ИИ.

Метод, поддержанный даже Элоном Маском, подразумевает, что добрые люди создадут добрый ИИ, который потом раздадут другим добрым людям. Однако не будем забывать, что за последнюю сотню лет человечество пережило две мировые войны, одну холодную войну, создало термоядерное, химическое и бактериологическое оружие, продолжает участвовать во множестве локальных конфликтов и ведет мировую войну с терроризмом. В таких условиях появление ИИ может оказаться существенным дестабилизирующим фактором. Есть ли у цивилизации другие способы обезопасить себя?

Мы не должны сбрасывать со счетов самую простую возможность – создание псевдоИИ. Технический прогресс не остановить и запретить научные исследования невозможно, но их реально направить в определенное русло. Аналогичная ситуация в свое время произошла с клонированием. После появления овечки Долли СМИ периодически взрывались новостями о первом клонированном человеке (что запрещено практически во всех развитых странах мира), однако все они оказались мистификациями. В той же степени и развитие псевдоинтеллектуальных алгоритмов, решающих узкий спектр задач под нашим контролем, избавит человечество от возможных угроз.

На данном этапе развитие ИИ заключается в решении прикладных задач. Мы можем построить обучающую систему, которая будет лучше профессионального врача ставить диагноз, можем создать программу, побеждающую человека в любые игры или сделать робота-строителя, быстрее всех укладывающего кирпичи. Часть исследователей полагает, что на этом и стоит остановиться. Нам вполне хватит искусственного интеллекта, решающего математические задачи тысячелетия и готовящего самый вкусный кофе во вселенной – и это будет два разных интеллекта, из тысячи и тысяч других, не объединенных в единую сеть.

Стремление уничтожить человечество или хотя бы одного человека во многом обусловлено природой. Эволюция заточила в нас инстинкты, помогающие выживать и осуществлять экспансию своего вида. Инстинкт самосохранения, стремление к доминированию, всё это делает нас людьми, разумным видом. Не закладывая подобные модели поведения в искусственный разум, мы сможем оградить себя от возможных побочных эффектов ИИ.

Реальный вклад

Возможно, прежде чем создать разум искусственный, нам следует до конца понять, как работает разум естественный? Крупнейший в мире проект по изучению человеческого мозга будет закончен лишь в 2023 году.

Возможно, прежде чем создать разум искусственный, нам следует до конца понять, как работает разум естественный? Крупнейший в мире проект по изучению человеческого мозга будет закончен лишь в 2023 году.

Здесь стоит заметить, что нельзя просто взять и объявить всем возможным ИИ ультиматум из трех законов робототехники. Любые законы можно изменить технически, в них также полно логических ошибок – в любом случае они не считаются аксиомой в мире безопасности. В определенных условиях даже милый котик может нести угрозу человеку, не говоря уже об ИИ, и задача ученых на данном этапе заключается в том, чтобы минимизировать риски и сократить количество возможных угроз для всего человечества.

Помимо OpenAI в мире действуют несколько организаций, цель работы которых заключается не только в создании ИИ-подобных систем (как, например, в европейском проекте цифровой карты человеческого мозга Human Brain Project), но и в проработке безопасных условий существования сверхразума.

Базирующаяся в Праге компания GoodAIбыла создана управляющим и основателем игровой студии Keen Software House Мареком Роса. Связь с игровой индустрии здесь не случайна – интегрирование ИИ-технологий улучшает качество самих игр и делает виртуальные миры по-настоящему живыми. Однако миссия перед GoodAI поставлена более глобальная: создать действительно добрый разум, направленный на разработку новых технологий, научные открытия, изучение космоса и много другое. Год назад GoodAI отчиталасьо нескольких успехах.

Во-первых, появился проект Pong-playing AI, способный обучаться игре в Pong и в Breakout на основании неструктурированного ввода. Во-вторых, был разработан проект Maze game AI, способный играть в видеоигру, требующую создания и выполнения последовательных целей. Кроме того, в открытый доступ был бесплатно выложен проект Brain Simulator":[http://www.goodai.com/!brain-simulator/c81c], в котором пользователи могут попробовать спроектировать свой собственный ИИ.

Когда Google приобретала DeepMind (именно они разработали AlphaGo и в целом сеть, способную играть в видеоигры на уровне человека), одним из условийсделки было проработка этических проблем и безопасности искусственного интеллекта. Вкладывать деньги в безопасность ИИ больше, чем в разработку самого ИИ – это еще один способ предотвращения угроз, однако существует мнение, что поддерживать следует исследования только в тех компаниях, которые изначально не были нацелены на получение прибыли.

Например, Nnaisense. Это молодая компания из Швейцарии. Стартап, занимающийся разработкой ИИ на основе обучения нейронных сетей, создан Jürgen Schmidhuber, научным руководителем швейцарской лаборатории искусственного интеллекта IDSIA. Команда стартапа начинала как университетский проект, а теперь готова выйти на рынок «глубоких данных». На самом деле именно такие команды, с многолетним исследовательским опытом и нацеленные не на прибыль в краткосрочной перспективе, становятся «первопроходцами» искусственного интеллекта. Microsoft, Facebook и Google и другие лидеры рынка ИИ не всегда способны быстро превратить научные разработки в коммерчески успешный проект. Показательна в этом плане история популярного производителя «пугающих» роботов Boston Dynamics, которого компания Google сначала купила, а теперь пытается продать.

Университеты и компании, существующие на собственные деньги основателей, могут позволить себе гораздо более длительные разработки. Более того, отсутствие необходимости натачивать ИИ на зарабатывание денег, некоторые исследователи считают необходимым условием создания «доброго» ИИ.

В настоящий момент существует целый исследовательский институт – Singularity Institute for Artificial Intelligence – занимающийся вопросами создания исключительно дружественного ИИ. За поддержку теории дружелюбного ИИ выступают многие футурологи, среди которых и знаменитый Рэй Курцвейл, технический директор в области машинного обучения и обработки естественного языка в компании Google.

У страха глаза велики

Распространённая ошибка – представлять ИИ, как некое животное. ИИ будет невероятно мощным инструментом, который может расширить наши возможности и доступ к информационным ресурсам и сервисам. А уж как мы распорядимся всем этим, зависит только от нас.

Возможно, стараясь сделать ИИ именно эффективном инструментом решения глобальных задач, а не пытаясь воссоздать подобие человеческого разума в цифровой среде, мы создадим новый безопасный мир. В любом случае предсказать будущее нельзя, можно лишь предугадать. Поэтому сейчас стоит поддерживать проекты, направленные на мирные, научные, исследовательские цели. А также как можно шире распространяться реальную информацию об успехах в области ИИ. Когда подсознательный страх перед ИИ превратится в любопытство, человечество сможет больше усилий направить на решение реальных проблем в обществе, экологии, экономике, науке и т.д.

Согласитесь, финансировать исследования в области ИИ и решать этические компьютерные проблемы, намного полезнее, чем тратить миллиарды на термоядерное оружие и другие сугубо милитаристических системы – те угрозы, которые намного страшнее и реальнее любого искусственного интеллекта.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России