Nature задаётся вопросом, воспроизводимы ли современные научные эксперименты?

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Случайно в потоке новостей и информации наткнулся на статью в Nature Scientific Reports. В ней представлены данные опроса 1500 учёных, посвящённого воспроизводимости результатов научных исследований. Если ранее данная проблема поднималась для биологических и медицинских исследований, где она с одной стороны объяснима (ложные корреляции, общая сложность исследуемых систем, иногда даже научный софт обвиняют), с другой стороны имеет феноменологический характер (например, мыши склонны вести себя по разному с учёными разных полов (1 и 2)).

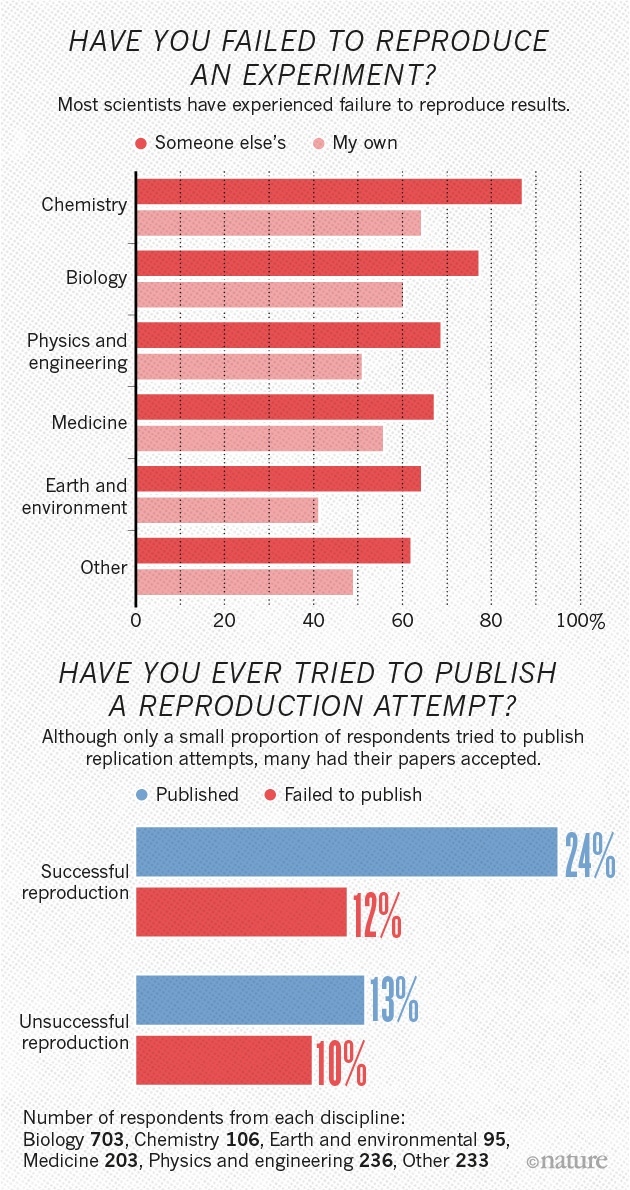

Однако не всё гладко и с более естественнонаучными дисциплинами, такими как физика и инженерные науки, химия, экология. Казалось бы, именно эти дисциплины зиждутся на «абсолютно» воспроизводимых экспериментах, проведённых в максимально контролируемых условиях, увы, потрясающий – во всех смыслах этого слова – результат опроса: до 70% научных исследований и экспериментов НЕвоспроизводимы не только другими группами учёных, НО и самим авторами/соавторами опубликованных научных работ!

Каждый кулик хвалит своё болото?

Хотя 52% опрошенных указывают на кризис воспроизводимости в науке, менее 31% считают опубликованные данные в корне неверными и большинство указало, что по-прежнему доверяют опубликованным работам.

**Вопрос: Существует ли кризис воспроизводимости результатов?*

Конечно же, не стоит рубить с плеча и линчевать всю науку как таковую лишь на основании данного опроса: половину опрошенных всё же составили учёные, связанные, так или иначе, с биологическими дисциплинами. Как отмечают авторы, в физике и химии уровень воспроизводимости и доверия к полученным результатам намного выше (см. график ниже), но всё же не 100%. А вот в медицине дела обстоят совсем плохо на фоне остальных.

На ум приходит анекдот:

- Какова вероятность встретить динозавра на улице?

- 50:50. Либо встретишь, либо нет.

Маркус Мунафо (Marcus Munafo) биологический психолог из университета Бристоля (Англия) имеет давний интерес к проблеме воспроизводимости научных данных. Вспоминая времена студенческой молодости, он говорит:

Один раз я пытался воспроизвести эксперимент из литературных источников, который мне показался простым, но я просто не смог этого сделать. У меня появился кризис доверия, но затем я понял, что мой опыт не был такой уж редостью.

Вопрос: Сколько уже опубликованных работ в Вашей отрасли воспроизводимы?

Широта и долгота глубина проблемы

Представьте, что Вы – учёный. Вам попадается интересная статья, но результаты/эксперименты не могут быть воспроизведены в лаборатории. Логично написать об этом авторам оригинальной статьи, спросить совета и задать уточняющие вопросы. Согласно опросу, менее 20% делали это когда-либо в своей научной карьере!

Авторы исследования отмечают, что, возможно, такие контакты и разговоры слишком сложны для самих учёных, потому что вскрывают их некомпетентность и несостоятельность в тех или иных вопросах или раскрывают слишком много деталей текущего проекта.

Более того, абсолютное меньшинство учёных попыталось опубликовать опровержение невоспроизводимых результатов, сталкиваясь при этом с противодействием со стороны редакторов и рецензентов, которые требовали преуменьшить сравнение с оригинальным исследованием. Стоит ли удивляться, что шанс сообщить о невоспроизводимости научных результатов составляет порядка 50%.

Первый вопрос: Пытались ли Вы воспроизвести результаты эксперимента?

Второй вопрос: Пытались ли Вы опубликовать свою попытку воспроизвести результаты?

Может быть стоит тогда внутри лаборатории хотя бы проводить проверку на воспроизводимость? Самое печальное, что треть респондентов даже НИКОГДА и не задумывалось о создании методик проверки данных на воспроизводимость. Только 40% указало, что они регулярно пользуются такими методиками.

Вопрос: Разрабатывали Вы когда-либо специальные методики/тех.процессы для улучшения воспроизводимости результатов?

Другой пример, биохимик из Соединённого Королевства, которая не пожелала раскрывать своё имя, говорит, что попытки повторить, воспроизвести работу для её лабораторного проекта просто удваивают временные и материальные затраты, ничего не давая и не превнося нового в работу. Дополнительные проверки проводятся лишь для инновационных проектов и необычных результатов.

И конечно же, извечные русские вопросы, которые стали пытать зарубежных коллег: кто виноват и что делать?

Кто виноват?

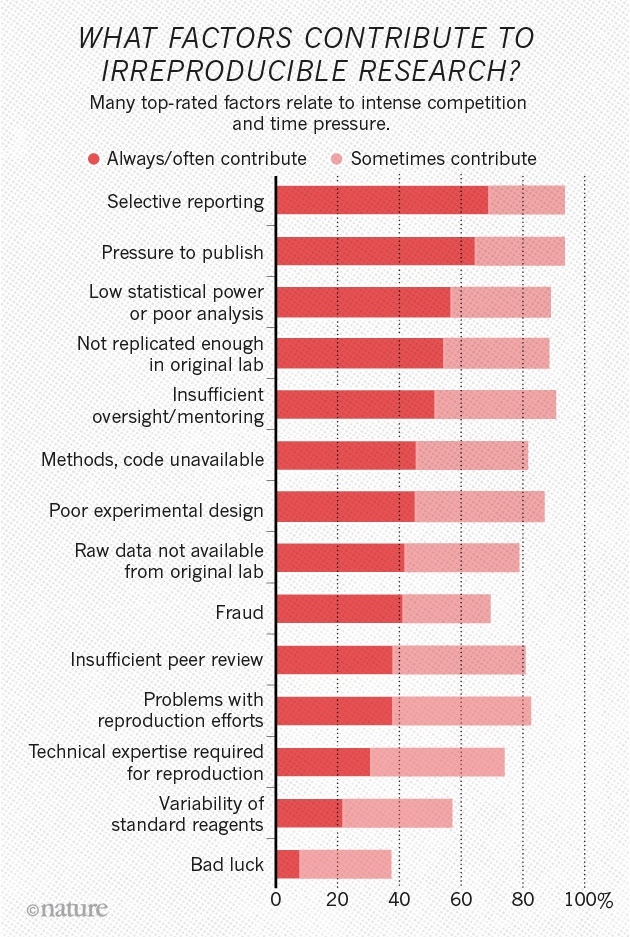

Авторы работы выделили три основных проблемы воспроизводимости результатов:

- Давление со стороны начальства, чтобы работа была опубликована в срок

- Выборочная отчётность (по всей видимости, имеется ввиду замалчивание некоторые данных, которые «портят» всю картину)

- Недостаточный анализ данных (в том числе статистический)

Вопрос: Какие факторы повинны в невоспроизводимых научных результатах?

Ответы (сверху вниз):

- Выборочная отчётность

- Давление начальства

- Плохой анализ/статистика

- Недостаточная повторяемость эксперимента в лаборатории

- Недостаточный надзор

- Отсутствие методика или кода

- Плохое планирование эксперимента

- Отсутствие сырых данных от первичной лаборатории

- Мошенничество

- Недостаточная проверка экспертами/рецензентами

- Проблемы с попытками воспроизведения

- Необходима техническая экспертиза для воспроизведения

- Вариативность стандартных реагентов

- «Ниудачка и пичалька»*

Что делать?

Из опрошенных 1500, более 1000 специалистов высказались за улучшение статистики при сборе и обработке данных, улучшение качества надзора со стороны боссов, а также более строгое планирование экспериментов.

***Вопрос: Какие факторы помогут повысить воспроизводимость?**

Ответы (сверху вниз):

- Лучшее понимание статистики

- Более строгий надзор

- Улучшенное планирование экспериментов

- Обучение

- Внутрилабораторная проверка

- Совершенствование практических навыков

- Стимулирование к формальной перепроверке данных

- Межлабораторная проверка

- Выделение большего количества времени для управления проектами

- Повышение стандартов научных журналов

- Выделение большего количества времени для работы с лабораторными записями*

Заключение и немного личного опыта

Во-первых, даже для меня, как учёного, результаты ошеломляющие, хотя привык уже к некоторой степени невоспроизводимости результатов. Особенно ярко это проявляется в работах, выполненных китайцами и индусами без стороннего «аудита» в виде американских/европейских профессоров. Хорошо, что проблему осознали и задумались над её решением(ями). Про российскую науку тактично умолчу, в связи с недавним скандалом, хотя многие честно выполняют свою работу.

Во-вторых, в статье замалчивается (вернее, не рассматривается) роль научных метрик и рецензируемых научных журналов в возникновении и развитии проблемы невоспроизводимости результатов исследований. В погоне за скоростью и частотой публикаций (читай, повышение индексов цитирования) резко падает качество и не остаётся времени на дополнительную проверку результатов.

Как говорится, все персонажи вымышлены, но основано на реальных событиях. Довелось как-то одному студенту проводить рецензирование статьи, ибо не у каждого профессора есть время и силы на вдумчивое чтение статей, поэтому собирается мнение 2–3–4 студентов и докторов, из которого складывается отзыв. Была написана рецензия, в ней указывалось на невоспроизводимость результатов по методике, описананой в статье. Это было наглядно продемонстрированно профессору. Но дабы не портить отношения с «коллегами» – ведь у них-то всё получается – рецензия была «скорректирована». И таких статей опубликовано 2 или 3 штуки.

Получается замкнутый круг. Учёный отправляет статью редактору журнала, где указывает «желаемых» и, основное, «нежелаемых» рецензентов, то есть фактически оставляя лишь положительно настроенных к авторскому коллективу. Они рецензируют работу, но не могут по-чёрному «гадить в комментах» и стараются из двух зол выбрать меньшее – вот список вопросов, на которые необходимо ответить, и мы тогда опубликуем статью.

Другой пример, о котором рассказывал редактор Nature буквально месяц назад – солнечные панели Грацеля. Из-за огромного интереса к данной тематике в научном сообществе (ведь все же хотят статью в Nature!), редакторам пришлось создать специальный опросник, в котором требуется указать уйму параметров, предоставить калибровки оборудования, сертификаты и прочее, чтобы подтвердить, что методика измерения КПД панелей соответствует некоторым общим принципам и стандартам.

И, в-третьих, когда в очередной раз вы услышите про чудо-вакцину, побеждающую всё и вся, новую историю о Джобсе в юбке, новые АКБ или вреде/пользе ГМО или излучения смартфонов, особенно, если это было пропиарено желтописателями от журналистики, то отнеситесь с пониманием и не делайте скоропалительных выводов. Подожди подтверждения результатов другими группами учёных, накопления массива и выборок данных.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России