Первые состязательные 3D-примеры для обмана нейросетей

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Давно известно, что небольшие целенаправленные изменения в картинке «ломают» систему машинного обучения, так что она классифицирует совершенно другое изображение. Такие «троянские» картинки называются «состязательными примерами» (adversarial examples) и представляют собой одно из известных ограничений глубинного обучения.

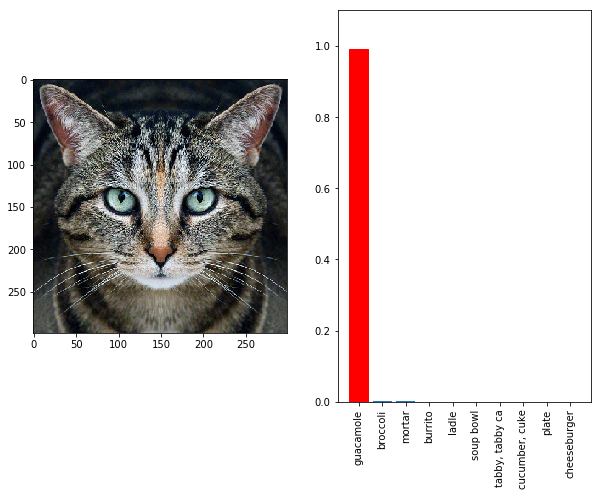

Работают они просто: нужно сделать градиентное восхождение в пространстве входных данных для генерации образцов, которые максимизируют предсказание класса для заданного класса. Например, если взять фотографию панды и добавить градиент «гиббон», мы заставим нейросеть классифицировать эту панду как гиббона. Черепаху можно выдать как винтовку (см. иллюстрацию вверху). Кот превращается в холодную закуску гуакамоле (см. под катом) — неважно. Любой объект превращается в любой другой для в глазах машинного интеллекта, потому что у ИИ особая система «зрения», отличная от человеческой.

Напечатанная на 3D-принтере черепаха распознаётся нейросетью как черепаха (зеленый контур), как винтовка (красный контур) или как другой объект (чёрный контур)

Напечатанная на 3D-принтере черепаха распознаётся нейросетью как черепаха (зеленый контур), как винтовка (красный контур) или как другой объект (чёрный контур)

До сих пор такая тонкая настройка градиента работала только на 2D-изображениях и была очень чувствительна к любым искажениям.

Фотография кошки распознаётся как гуакамоле в классификаторе InceptionV3

Фотография кошки распознаётся как гуакамоле в классификаторе InceptionV3

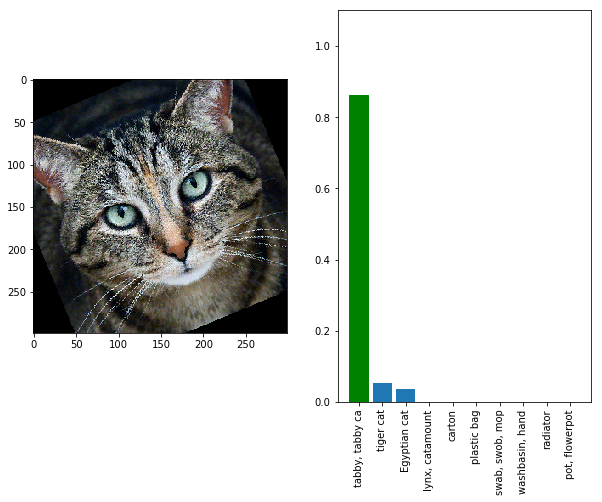

Посмотри на котика под другим углом или с другого расстояния — и нейросеть уже снова видит в нём кота, а не холодную закуску.

Фотография кошки снова распознаётся как кошка в классификаторе InceptionV3, если немного повернуть её

Фотография кошки снова распознаётся как кошка в классификаторе InceptionV3, если немного повернуть её

То есть в реальности такие состязательные примеры не будут эффективны из-за зума, шума цифровой камеры и прочих искажений, которые неизбежно возникают в реальности. Это неприемлемо, если мы хотим надёжно и устойчиво обманывать системы компьютерного зрения в офлайне. Но теперь появилась надежда, что эта задача людям по силам. Исследователи из Массачусетского технологического института и независимой научно-исследовательской группы LabSix (составлена из студентов и выпускников MIT) создали первый в мире алгоритм, который генерирует состязательные примеры в 3D. Например, в видеоролике ниже показана черепашка, которая устойчиво распознаётся классификатором Google InceptionV3 как винтовка (rifle) почти под любым углом.

Алгоритм способен генерировать не только черепашек, но и любые произвольные модели. Для образца исследователи напечатали также бейсбольный мяч, который классифицируется как эспрессо (кофе) под любым углом, а также создали большое количество других моделей — своеобразных оптических иллюзий для ИИ.

Обман машинного зрения работает даже в том случае, если объект на фотографии находится в семантически нерелевантном контексте. Очевидно, что нейросеть при обучении не могла видеть ни винтовку под водой, ни эспрессо в перчатке кетчера.

Состязательные примеры в 3D: черепаха, которая для нейросети InceptionV3 выглядит как винтовка, и бейсбольный мяч, который выглядит как эспрессо

Состязательные примеры в 3D: черепаха, которая для нейросети InceptionV3 выглядит как винтовка, и бейсбольный мяч, который выглядит как эспрессо

Хотя метод «заточен» именно для конкретной нейросети, но в комментариях к прошлым научным статьям на эту тему обращали внимание на ремарку исследователей, что, скорее всего, атака подействует на многие модели, обученные на данном конкретном наборе данных — включая разные архитектуры свёрточных сетей и даже линейные классификаторы. Так что для проведения атаки достаточно гипотезы, на основе каких данных могла обучаться модель.

«В конкретных терминах это означает, что вполне вероятно, появляется возможность создать дорожный знак о продаже дома, который для человеческих водителей кажется совершенно обычным, но для беспилотного автомобиля будет казаться пешеходом, который внезапно появился на тротуаре, — сказано в научной работе. — Состязательные примеры вызывают практический интерес, который нужно учитывать по мере того, как нейросети становятся всё более распространёнными (и опасными)».

Для защиты от подобных атак разработчики ИИ будущего может держать в секрете информацию об архитектуре своих нейросетей, а главное — о наборе данных, который использовался при обучении.

Научная статья опубликована 30 октября 2017 года на сайте препринтов arXiv.org (arXiv:1707.07397v2).

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России