Что такое «интуитивный интерфейс» в чатботах, виртуальных ассистентах, аватарах и социальных роботах?

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Поговорим о бизнесе и трендах в сфере умных систем.

Очень быстрыми темпами в нашу жизнь входит работа с большими данными и «умными системами». И, как и у любого тренда, здесь сразу очевидным образом выявляется «узкое место», а именно – интерфейс. Какой бы «умной» ни была система, с какими бы данными и насколько бы качественно она ни работала, результат ее работы должен быть понятен человеку. Сама работа с такой системой должна быть удобна пользователю. Наравне с внедрением цифровой трансформации, Big Data, IoT систем бизнес будет в явном виде требовать создания эргономичного и максимально интуитивного интерфейса взаимодействия человека с этими системами. Проблема качественных интерфейсных решений будет проявляться все более и более остро. И особенно остро эта проблема встает там, где с системой имеет дело не «специально обученный профессионал», а обычный пользователь.

Далее мы задались вопросом: что же такое «качественное интерфейсное решение»? Ответ на него мы начали искать в конкретных кейсах. И логика подсказала нам посмотреть внимательнее на кейсы с недавней международной конференции CES2018, вот они:

Да, это тот самый ролик про разговор с LG Cloi (но видео интересно далеко не только этим)

А вот еще несколько примеров:

Virtual assistants once again dominate CES 2018

Honda Brings Robotic Devices to CES 2018

Кейсов очень много, прежде всего они указывают на огромное разнообразие интерфейсных решений, упорядочить которые достаточно сложно. Иногда в таких решениях бывает непросто найти и бизнес-составляющую – какие конкретно бизнес-задачи (задачи клиента) они должны решать и в каком функционале это должно выражаться.

Давайте посмотрим на несколько пунктов в отчете известного аналитического агентства Gartner «Top Trends in the Gartner Hype Cycle for Emerging Technologies, 2018». На самом пике технологических ожиданий (Expectations) мы видим виртуальных ассистентов (Virtual Assistants) и умных роботов (Smart Robots). Стоит также обратить внимание и на этот отчет «Gartner Market Guide for Conversational Platforms, 20 June 2018».

Неплохим опытом систематизации происходящего на рынке для нас выступил документ от PwC: «The Relevance and Emotional Lace” PwC Digital Services, Holobotics Practice».

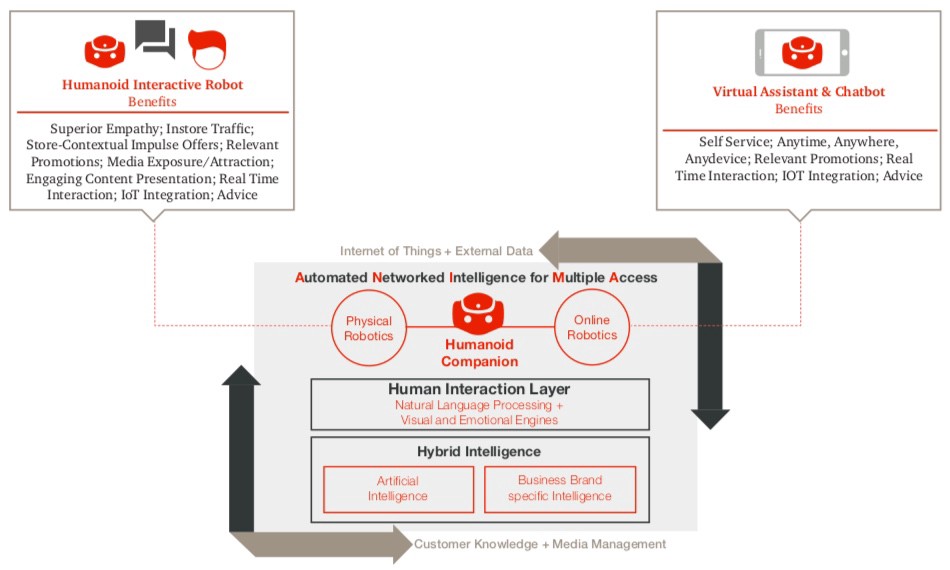

Анализ объединяет чатботов (Chatbots), виртуальных ассистентов (Virtual Assistants) и интерактивных роботов (Humanoid Interactive Robots) в один тип интерфейсного решения – Humanoid Companion. Причем разделяет это решение на 2 подтипа – Physical Robotics и Online Robotics. Заметим, что сейчас указанные подсегменты рынка, решающие, по сути, похожую задачу создания качественного и эргономичного интерфейсного решения, ощутимо разведены – ими часто занимаются различные специализированные производители и поставщики, разные аналитики и т.д. Разбиение на подтипы в документе PwC основано на критерии «какое железо положено в основу решения» — физической робот, колонка, компьютер.

Automated Network Intelligence for Multiple Access. Credit: PWC. Available here.

Automated Network Intelligence for Multiple Access. Credit: PWC. Available here.

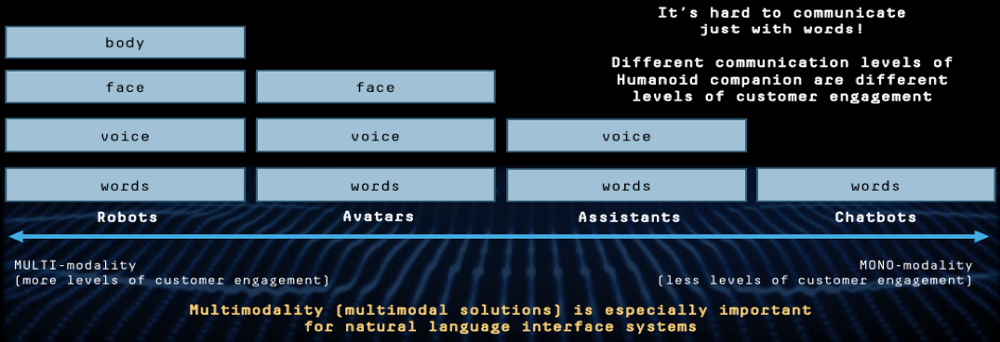

Мы предлагаем ввести другой критерий, который, на наш взгляд, позволит получить более ясную картину и более четкую систематизацию такого типа решений. Этот критерий – модальность взаимодействия, модальность, которая включена в интерфейсное решение. Рассмотрим детальнее.

Существуют 4 основных уровня/модальности, на которых происходит взаимодействие (удобное и эргономичное для человека): слова, голос, лицо, тело. Общаясь друг с другом, мы включаем в общение часть этих модальностей или все модальности сразу. Именно это мы сейчас и видим в интерфейсных системах: разнообразные решения, направленные на одну и ту же задачу, но различающиеся в зависимости от того, какие модальности в них включены.

Credit: Neurodata Lab.

Credit: Neurodata Lab.

Приведем примеры (компании для примеров взяты из обзора Forrester «The Top 10 Chatbots For Enterprise Customer Service»):

Chatbot — в такого рода решениях используется только одна модальность – слова, текстовое взаимодействие.

- Решения от компании Next IT

- Чатботы от компании Nanorep

- Чатбот для построения чатботов от компании Reply.ai

Assistant – виртуальный ассистент предполагает наличие второй модальности – голоса, взаимодействия с помощью речи:

- Иногда это просто говорящий чатбот (IPsoft)

- Но в первую очередь сюда относятся решения, позволяющие вести полноценный диалог (Nuance)

Avatar – это более сложные и более редкие решения, сейчас их можно увидеть в основном в HR-сфере:

- Andi the Interview Coach — Multi-Modal Skype Bot, интересное решение от Botanic Technologies

- HR-решение от российского стартапа (Робот-рекрутер Вера), вот так он выглядит в работе:

Есть также некоторые, скажем так, промежуточные решения, которые используют разные модальности в зависимости от стороны взаимодействия (например, человек пишет, ассистент говорит и двигается, и так далее). Любопытные примеры:

Robot – и наши любимые Human Robots – мультимодальные коммуникативные агенты, работающие сразу на уровне 4 модальностей – слова, голос, лицо и тело.

Vector by Anki. Credit: Anki.

Vector by Anki. Credit: Anki.

Что особенно важно: включение новых модальностей с одной стороны открывает перед системой совершенно новые возможности, а с другой стороны требует дополнительных технологий — новых, передовых технологий в сфере ИИ, в частности, в сфере эмоционального искусственного интеллекта, направленных на работу с Natural Language Processing (обработкой естественного языка) и сфокусированных на (интерфейсных) решениях именно такого типа.

Если вы хотите получать наши новые публикации напрямую, если статья заинтересовала вас, и вы хотели бы получить доступ к демо-стенду, показывающему работу наших Emotion AI продуктов, вы можете связаться с автором статьи:

Автор: Olga Serdiukova

Chief Marketing Officer and Partner Development Director

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России