Почему дипфейки в будущем не сулят ничего хорошего

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

*Автор: xlebanёt *: Исследователи из лаборатории SAND Lab при Чикагском университете утверждают, что доступные широкой общественности программы клонирования голоса развиваются угрожающе быстро. В частности, создаваемые при помощи подобных технологий голосовые дипфейки могут сбить с толку как людей, так и смарт-устройства с голосовым управлением. Но не только голосовые, а также и другие дипфейки представляют угрозу.

Дипфейки уже используются в рекламе, моде, журналистике и обучении. Однако больше 90% подделок созданы, чтобы навредить репутации, — например с помощью порнографических роликов. В 2019 году общие денежные потери бизнеса из-за дипфейков приблизились к отметке $250 млн в 2020 году.

Примеры атак с использованием дипфейков

- Атака на руководителя энергетической компании: Эта афера с использованием дипфейка в 2019 году является первой известной атакой с использованием данной технологии, и она иллюстрирует «темную» сторону возможностей технологии дипфейков. Как в классическом случае корпоративного вымогательства, генеральный директор энергетической фирмы получил телефонный звонок якобы от своего босса. На самом деле, это был поддельный голос, сгенерированный искусственным интеллектом, но на слух это невозможно было определить, поэтому генеральный директор спокойно выполнил его поручение о переводе 243 000 долларов США в течение часа. Программа смогла сымитировать не просто голос человека, но его тональность, интонации и немецкий акцент. Правда вскрылась, когда мошенники попытались провернуть тот же фокус во второй раз. Увы, полиция не смогла идентифицировать личности преступников, а вместе с ними не удалось найти и деньги.

- Атака на техническую компанию: В этой неудачной попытке аудио-дипфейка в 2020 году сотрудник одной технической компании получил странное голосовое сообщение от кого-то, чей голос был очень похож на голос генерального директора фирмы. В сообщении содержалась просьба о «немедленной помощи для завершения срочной деловой сделки». Однако сотрудник компании, следуя своим подозрениям, сообщил об этом в юридический отдел фирмы. Хотя эта атака с использованием дипфейка в конечном счете не увенчалась успехом, но она является ярким примером тех типов атак, которые мы ожидаем увидеть в большом объеме по мере того, как технологические достижения и инструменты для создания дипфейков будут становиться все более доступными. Письма на электронной почте и голосовые дипфейки оказались частью продуманной мошеннической операции, в которой, по данным полиции ОАЭ, были задействованы не менее 17 человек из разных стран.

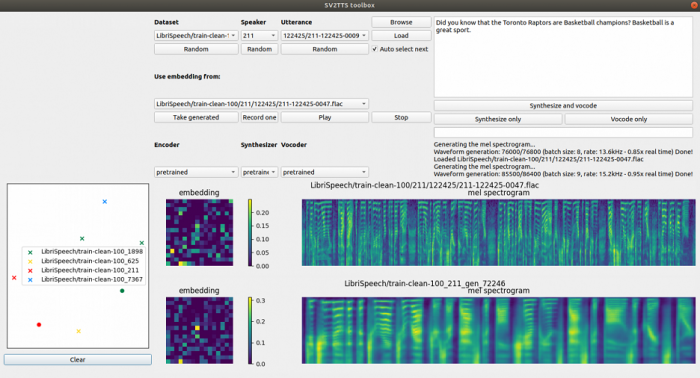

Команда экспертов из лаборатории SAND Lab (Security, Algorithms, Networking and Data Lab) протестировала доступные на платформе Github программы клонирования голоса, чтобы узнать, смогут ли они прорваться сквозь защиту системы безопасности распознавания голоса умных колонок Alexa, WeChat и Azure.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России