Яндекс разработал языковую модель для генерации текстов

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Яндекс представил нейросетевой языковой алгоритм генерации текстов YaLM и сервис «Зелибоба» на его основе. Сервис умеет подбирать следующее слово в предложении и благодаря этому писать небольшие тексты на основе нескольких слов, введенных пользователем. Языковая модель, лежащая в основе «Зелибобы», была обучена на нескольких терабайтах русскоязычных текстов, в том числе статьях Википедии, новостных заметках и постах в социальных сетях.

От редактора. Вскоре после публикации заметки Яндекс закрыл доступ к сервису. «В результате ошибки мы раньше времени открыли демо-версию технологии, которая еще находится в стадии внутреннего тестирования. Мы обязательно расскажем обо всем подробнее – но немного попозже», — сообщил представитель компании.

В последние несколько лет в области алгоритмов обработки естественного языка произошел заметный прогресс, связанный с несколькими факторами. Во многом это связано с разработанной в 2017 году исследователями из Google архитектурой нейросетей, называемой Transformer. Наиболее известна архитектура Transformer по семейству нейросетевых моделей GPT, разработанных OpenAI. Начиная с модели GPT-2 качество создания текста стало настолько высоким, что разработчики, опасаясь использования его для недобросовестных целей, решили не выкладывать в общий доступ полную модель, ограничившись упрощенной.

Качество создаваемого текста в нейросетях этого типа зависит от разных факторов, во многом от количества используемых в сети параметров. В GPT-2 их было полтора миллиарда, а в GPT-3, представленной в прошлом году, уже 175 миллиардов, что позволило после обучения всего на нескольких примерах выполнять задачи по работе с текстом разного типа, в том числе писать стихи, отвечать на вопросы и переводить тексты.

Российские разработчики тоже работают над созданием нейросетей на архитектуре Transformer, но обученных для работы с русскоязычными текстами. В конце 2020 года разработчики из Сбера опубликовали русскоязычную версию GPT-3 с 760 миллионами параметров, а теперь русскоязычную языковую Transformer-модель представил Яндекс.

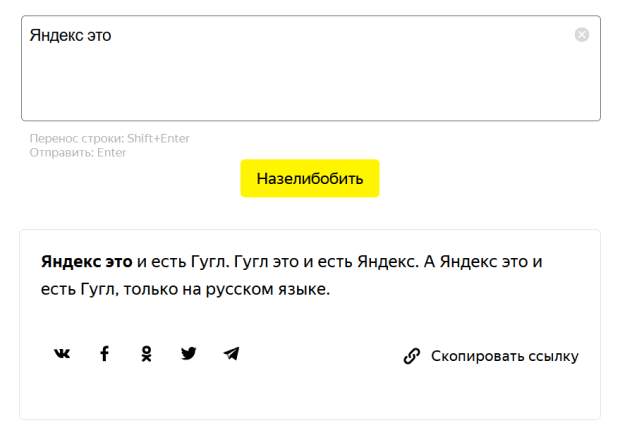

Как и GPT-3, алгоритм YaLM (Yet another Language Model) от Яндекса обучен предсказывать следующее слово в текстовой последовательности. Совмещая предсказанные слова, модель может дополнять предложенное ей слово или предложение еще несколькими словами или предложениями. Для демонстрации работы алгоритма разработчики создали сервис «Зелибоба». В нем пользователь может ввести текст и получить от алгоритма продолжение. Также в «Зелибобе» можно выбрать стиль дополненного текста, например, тосты, подписи к постам в Instagram или пацанские цитаты.

Пример работы алгоритма / Яндекс

Пример работы алгоритма / Яндекс

Разработчики отмечают, что алгоритм крайне быстро дообучается для работы в новом стиле — для этого ему необходимо от пяти до нескольких десятков примеров в целевом стиле.

Авторы алгоритма создали несколько моделей, отличающихся количеством параметров — от 1 до 13 миллиардов (в «Зелибобе» используется версия с 3 миллиардами параметров). Все они обучались на разнообразных образцах русскоязычных текстов, среди которых были статьи из Википедии, книги, посты в социальных сетях и новостные заметки. Разработчики использовали как свои, так и общедоступные датасеты, в том числе Taiga и RDT.

Представитель Яндекса сообщил N + 1, что в ближайшее время компания расскажет, в каких других сервисах планируется использовать новый алгоритм генерации текстов, других подробностей о возможном применении семейства YaLM не сообщается.

Пример работы алгоритма / Яндекс

Пример работы алгоритма / Яндекс

В бенчмарке русскоязычных моделей для обработки естественного языка RussianSUPERGLUE алгоритм YaLM (версия с миллиардом параметров) занял второе место, уступив модели от разработчика neverrixx.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России