Неразумный алгоритм. Почему искусственный интеллект — это инструмент для узких задач

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Блейк Лемуан проработал в Google семь лет. Осенью 2021 года он занялся тестированием разговорного агента LaMDA, которого корпорация представила незадолго до этого. Модель была обучена в первую очередь на диалогах, а не повествовательных или аналитических текстах и потому прекрасно играла роль собеседника — настолько, что через год Лемуан посоветовал ей найти адвоката и заявил, что признает в ней разумное существо.

Даже более, чем разумное: в интервью для Washington Post, равно как и в отчете для руководства Google (его Лемуан, вопреки запрету, выложил в открытый доступ), инженер использует эпитет sentient, а значит, и вовсе считает машину способной испытывать чувства. Полная версия отчета с предисловием доступна через VPN.

А с декабря попробовать себя в роли Блейка Лемуана может каждый: компания OpenAI предоставила широкой публике возможность побеседовать со своим разговорным агентом ChatGPT, и теперь разговоры с машиной о душе в глубинах ее нейросетей прямо сейчас ведут десятки людей. Давайте разберемся, куда заводят эти разговоры и почему у нас до сих пор нет даже способа поискать личность нового типа между строчек программного кода.

В заголовок документа, который Лемуан представил сначала руководству, а затем и широкой общественности, вынесен вопрос: «Способна ли LaMDA переживать чувственный опыт?» («Is LaMDA sentient?»). Авторы перечисляют, что в беседах с ними модель говорила о своих чувствах и эмоциях, вспоминала о прошлом и выражала беспокойство о своем будущем, занималась чем-то похожим на самоанализ, а также описывала то, на что похож опыт «обретения разума», и рассуждала о природе своей души.

Уже после выхода интервью Лемуан добавил к уже сказанному, что его целью было не доказать, что в недрах Google родилось и осознало себя как личность существо по имени LaMDA, а привлечь внимание к тому, что этот вопрос требует основательного исследования, поскольку строгих научных критериев, следуя которым можно было бы однозначно ответить на этот вопрос, нет.

Мы не знаем, будут ли в Google всерьез разбираться с тем, как правильно понимать природу LaMDA. Уволенный инженер убежден, что языковая модель — личность, разумная и чувствующая. В отсутствие строгих научных критериев Лемуан предлагает смириться с тем, что пока что соглашаться (или не соглашаться) с этим можно только с опорой на личные ценности и религиозные убеждения.

Что она понимает

Все разговоры об искусственном интеллекте рано или поздно упираются в тест Тьюринга. Это эксперимент, который придумал Алан Тьюринг в 1950 году, чтобы положить прагматический конец дискуссиям о том, может ли машина быть разумной.

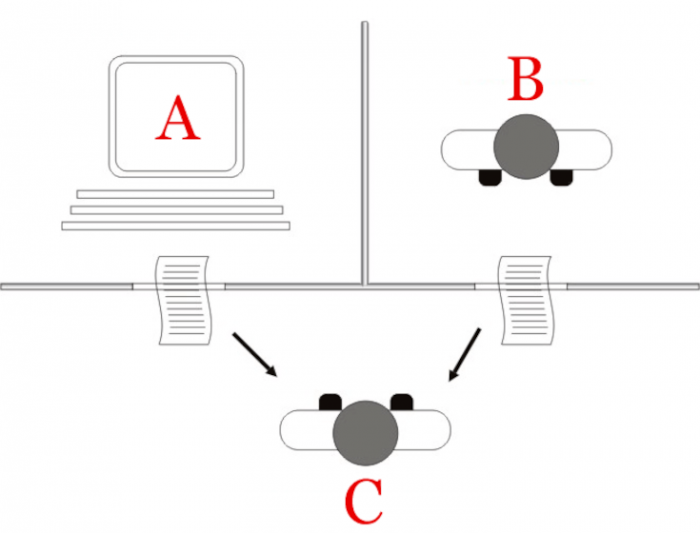

Тест Тьюринга выглядит так: два человека, одна машина, три комнаты. Один из людей — экспериментатор. Он ведет беседу с теми, кто находится в других комнатах, проталкивая в щель под дверью записки (во времена Тьюринга чаты еще не придумали). Его цель — определить, в какой комнате сидит человек, а где машина. И если он ошибется, то следует признать, что машина разумна.

С тех пор у нас не нашлось способа ответить на этот вопрос лучше: единой теории для интеллекта, сознания, внимания и всего остального, что входит в огромное понятие «ум» (mind), так и не появилось.

У психологов нет теста на наличие интеллекта, но есть целый букет тестов на измерение всевозможных его проявлений: пространственного мышления, работы памяти и тому подобного (подробнее об этом мы рассказываем в одном из эпизодовhttps://stroki.mts.ru/book/7059?active=audio нашего подкаста «Это сигнал»). Нет и понятных критериев, по которым мы определяем sentience — способность испытывать переживания (подробнее об этом читайте в материалах «Боль головоногая» и «Больше боли»). А для разума у нас есть только прагматические решения, тесты Тьюринга и Лавлейс, которые предлагают не думать о природе интеллекта ради того, чтобы ответить на бинарный вопрос о его наличии в случае, когда речь идет о конкретной машине. Никакой теории интеллекта эти инструменты не предполагают, это просто утиный тест, где утка не интеллект как таковой, а его частный случай в человеческом лице.

Поэтому при желании можно считать, что эпоха разумных машин давно наступила. Люди регулярно принимают искусственный интеллект за людей — как в рамках специализированных конкурсов, так и просто беседуя в сети с очередным ботом, будь то цифровой помощник Сбера, Тинькоффа и других банков. С помощью ИИ можно успешно синтезировать голос и выдать себя за другого человека или даже примерить лицо реального или несуществующего человека, которое ничем не отличается от лиц настоящих людей. Да и капчу (CAPTCHA, Completely Automated Public Turing test to Tell Computers and Humans Apart) некоторые из роботов прекрасно разгадывают, а тысячи людей ежедневно справляются с ней не с первого раза.

С другой стороны, еще полвека назад философ и лингвист Джон Серл описал мысленный эксперимент, который ставит под сомнение легитимность теста Тьюринга в качестве эффективного критерия на разумность.

Представьте, что в тесте Тьюринга участвуют не два человека и искусственный интеллект, а три. А еще тест проводится на китайском языке, и один из испытуемых его знает, а другой нет (в оригинальной формулировке, кстати, этим человеком был Джон Серл). Однако у Серла в комнате есть бесчисленный набор справочников и прочих руководств по тому, как формулировать высказывания на китайском языке в ответ на любые вводные данные. И когда он читает письма, написанные экспериментатором, то обращается к этой системе и за приемлемое время генерирует ответы, которые вполне удовлетворяют их адресата.

Обратите внимание, говорит Серл, что человек в «китайской комнате» проходит тест Тьюринга, при этом не понимая сути разговора, который он поддерживает. Разумным такого агента Серл (и многие его сторонники) признать не может. Следовательно, тест Тьюринга не может быть «детектором разума».

Как она понимает

Тем не менее достижения современного искусственного интеллекта впечатляют.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России