Ученые все чаще не могут объяснить, как работает ИИ. Теория «черного» и «белого» ящика

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Блог компании GetMatch.ru. Какое у вас любимое мороженое? Шоколадное, ванильное, фисташки, крем-брюле? Вы легко дадите ответ. Но если вас спросят, почему именно этот конкретный вкус, тут уже дать конкретный ответ станет гораздо сложнее. Большинство максимум придумают, что так у них устроены вкусовые рецепторы. Но почему они устроены именно так, и почему тогда нам иногда хочется пробовать другие виды мороженого?

Если бы мы подвергали анализу такие повседневные вещи в своей жизни, мы скоро бы поняли, что часто не можем точно понять причины своих предпочтений, эмоций или желаний. Не можем разобраться с тем, что на самом деле происходит у нас в мозгу. А что тогда с ИИ? В него заложены конкретные программы и алгоритмы, значит, мы можем определить, чем конкретно он руководствуется при принятии тех или иных решений, правда? Или хотя бы примерно предсказать, какими они будут?

На самом деле, с ИИ всё обстоит еще хуже. Чем дальше развиваются технологии, тем чаще мы вообще не можем понять, что происходит там внутри. А значит, и не можем быть уверены, стоит ли нам доверять таким решениям. Исследователи всё чаще предупреждают, чтобы при разработке моделей ИИ мы уделяли больше внимания тому, как и почему они выдают определенные результаты, а не тому, как точно и быстро они могут их выдавать.

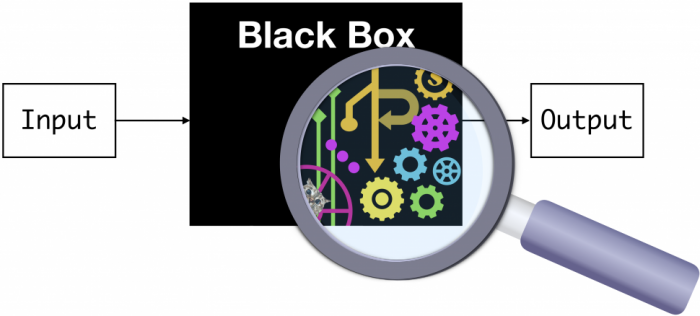

Черный ящик

У людей, которые разрабатывают ИИ, все чаще возникают проблемы с объяснением того, как он работает, и пониманием, почему он дает те результаты, которые дает. Глубокие нейронные сети, имитирующие работу нейронных сетей нашего мозга, часто, кажется, отражают не только человеческий интеллект, но и необъяснимость глубин человеческого сознания.

Большинство систем ИИ представляют собой классические модели черного ящика. То есть, эти системы рассматриваются только с точки зрения того, что у них на входе, и того, что на выходе. Разработчики просто получают результаты, и сравнивают их с теми, которые хотели бы получить. Они не пытаются «расшифровать черный ящик» или понять те непрозрачные процессы, которые выполняет система, пока занимается поиском результата.

Например, если предоставить этому «черному ящику» данные о каждом вкусе мороженого, а потом о вашем экономическом состоянии, социальном положении, возрасте, образе жизни и так далее — он, вероятно, сможет догадаться, какой вкус мороженого вам нравится больше всего. А если система выдаст неверный результат, всегда можно «скормить» ей еще больше данных, привязать разные коэффициенты, и делать это, пока результат совпадет. Причем не только для вас, а и для 100 случайно выбранных людей. После этого можно выходить с научной работой, запускать сервис, идти к инвесторам, выходить на компании по продажам мороженого. И говорить, что у вас есть система, которая работает.

Но правда ли она работает? Какие факторы она учитывает, как приходит к своим выводам? Не будет ли такого, что, однажды, обработав другой набор данных, та же модель решит, что нужно рекомендовать всем людям мороженое с насекомыми или со вкусом пиццы?

В конце концов, уже есть несколько долго и успешно работавших ИИ, которые провалились. Например, в США большой скандал вызвали системы автоматического одобрения онлайн-заявлений на ипотеку. Они работают уже несколько лет, упрощая работу крупнейших ипотечных кредиторов страны, и вполне успешно повышая их прибыль. Но потом оказалось, что для этого они автоматически отклоняли 80% заявлений от темнокожих заявителей. Используя обширные базы данных, они определили, что люди с такими фамилиями и именами в целом живут в более дешевых домах, а значит, запросы от похожих людей в целом проще отменять.

Похожие «факапы» уже случились с приглашениями школьников в университеты и даже с рекрутингом. Опять же, всё в лучших традициях Германии тридцатых годов: если у вас «не такая» фамилия, нужно будет очень много аргументов, чтобы система всё-таки решила рассмотреть вашу кандидатуру. Когда такие ИИ внедряли, казалось, они позволят навсегда отказаться от расизма в университетах, при покупках домов и при приеме на работу. Но оказалось, что на деле они только привязались к текущим тенденциям, успешно нашли эти паттерны, и дополнительно их усилили.

Но в США хотя бы есть четкий маркер, позволяющий быстро определять такой провальный ИИ. «Тест по темнокожему». А что делать с теми ИИ, которых нельзя прогнать через такой тест? Или теми, которые разработаны в странах, где просто нет такой выборки? По каким еще параметрам они полностью проваливаются, но мы просто этого не замечаем?

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России