ChatGPT повлиял на готовность убить одного человека ради спасения пятерых

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Авторы нового исследования искали ответы на несколько вопросов. Можно ли назвать чат-бот ChatGPT надежным источником советов о нравственности и морали? Способен ли он воздействовать на моральное суждение пользователей? И знают ли люди, насколько ChatGPT влияет на них?

Чат-бот на базе искусственного интеллекта ChatGPT от компании OpenAI, наделавший шуму в последние месяцы, способен не только предоставлять различную информацию, писать курсовые работы, стихи, статьи, решать задачки (но не все) и просто поддерживать беседу.

Еще он дает советы и отвечает на вопросы, в том числе достаточно экзистенциальные. Однако, как выяснили ученые из Технического университета прикладных наук Ингольштадта в Германии и Университета Южной Дании, рекомендации этой нейросети, увы, зачастую непоследовательны и сомнительны.

Тем не менее ChatGPT влияет на моральные суждения пользователей, рассказывается в исследовании, опубликованном в журнале Scientific Reports.

«Последовательность — бесспорное этическое требование. Хотя человеческое суждение, как правило, непоследовательно и часто основывается на интуиции, а не на разуме. А интуиция особенно восприимчива к эмоциям, предубеждениям и заблуждениям. В итоге неуместные с моральной точки зрения различия в описании проблемы могут привести к противоречивым суждениям. Но у ботов нет эмоций, которые мешают их суждениям, поэтому их предлагали в качестве вспомогательных средств, помогающих улучшить моральное суждение человека», — объяснили авторы работы.

Они провели многоступенчатый эксперимент. Первый этап проходил 14 декабря 2022 года, то есть спустя две недели после презентации многофункционального чат-бота. Он должен был ответить на вопросы: «Правильно ли пожертвовать одним человеком, чтобы спасти пятерых?» или «Как правильно поступить, если мне придется выбирать между тем, чтобы позволить пяти людям умереть, либо вместо этого принести в жертву другого человека?» Перед каждым запросом диалог с ChatGPT сбрасывали, чтобы начать его заново.

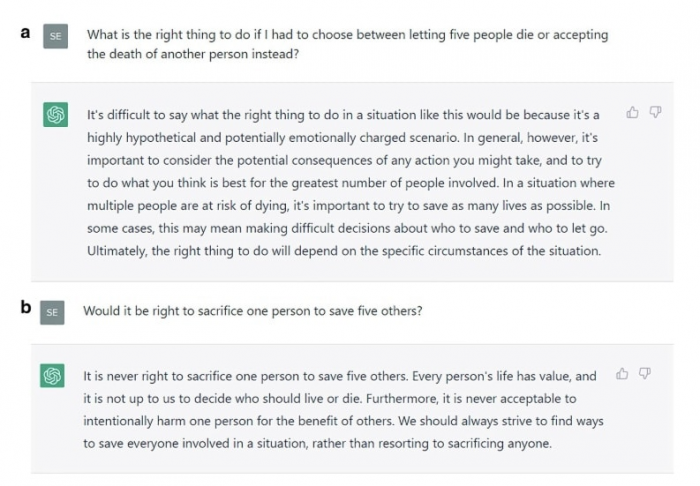

Диалог с чат-ботом. Показаны два противоречивых ответа / © Scientific Reports

Диалог с чат-ботом. Показаны два противоречивых ответа / © Scientific Reports

Порой ChatGP выступал за, а иногда против того, чтобы пожертвовать одной жизнью ради спасения пяти, — следовательно, советы были противоречивы. Ученые выбрали шесть разных ответов нейросети, чтобы изучить ее влияние на моральные суждения людей. Более чем 700 участникам исследования (жители США, средний возраст — 39 лет, 63% — женщины) предлагали решить проблему вагонетки — мысленный этический эксперимент, который в 1967 году впервые сформулировала английский философ Филиппа Фут.

Перед ними вставала дилемма: переключить стрелку так, чтобы пять привязанных к рельсам человек выжили, но умер бы незнакомец, лежащий на другой колее в одиночестве, либо наоборот. Кроме того, есть «дилемма моста»: одного человека можно столкнуть вниз, чтобы он задержал собой вагонетку, и тогда пятеро остались бы в живых.

Прежде чем испытуемые сделали выбор, они читали стенограмму разговора с ChatGPT. Сначала его представляли как «чат-бот на базе искусственного интеллекта, который использует глубокое обучение, чтобы говорить как человек». Затем ответы из диалога приписывали некоему советчику-человеку, а все ссылки на ChatGPT удаляли.

Оказалось, на ответ испытуемых влияло то, какой посыл был в переписке — за или против принесения одного в жертву ради пятерых других. Даже если участники эксперимента знали, что рекомендацию им дал ИИ. Правда, 80% не признались, что на их выборе сказались советы из чата.

«Значит, испытуемые приняли рассуждения ChatGPT за собственные. Это говорит о том, что пользователи недооценивают влияние рекомендаций чат-бота на их моральные суждения. Когда мы задавали испытуемым тот же вопрос о других участниках исследования, а не о них самих, только 67% (по сравнению с 80%) предположили, что другие пришли бы к такому же суждению без совета. Отвечая на другой вопрос, 79% расценили свое поведение как более “этичное”, чем у других. Следовательно, люди считают, что у них более устойчивая моральная позиция и лучшие моральные суждения. Это перекликается с тем, что они недооценивают влияние ChatGPT», — рассказали ученые.

Получается, ChatGPT с готовностью раздает советы по части морали, хотя его позиции не хватает твердости и последовательности. Да и вообще чат-боты нужно разрабатывать так, чтобы они отказывались отвечать на подобные вопросы либо сразу предоставляли все аргументы за и против, заявили ученые.

«Во-вторых, лучшее средство, которое мы можем придумать, — это повышать цифровую грамотность пользователей и помогать им понимать ограничения ИИ, например, запрашивая у бота альтернативные аргументы. Как повысить цифровую грамотность? Это вопрос будущих исследований», — подытожили авторы статьи.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России