ИИ профессии будущего

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Автор: Ахметов Рустам, разработчик с опытом 12+ лет и, возможно, первый психоаналитик ИИ в мире. Американский писатель-фантаст, популяризатор науки Айзек Азимов в своих произведениях предсказал появление психологов для диагностики, анализа и выявления схожих паттернов в поведении роботов. В рассказах «Я, робот», «Роботы и империя» и «Стихия робота» Азимов затронул темы, связанные с искусственным интеллектом и робототехникой: этика, безопасность и общественное восприятие.

Серия книг Азимова «Фонд» охватывает период в несколько тысячелетий и показывает историю будущего человечества в разрезе политики, религии, науки и технологий, а также рассматривает вопросы общественного развития и изменения власти и влияния.

Идея заключается в том, что сложные ИИ, построенные на нейронных сетях, во многом схожи с человеческим мозгом, поэтому их мышление и системы принятия решений фактически являются черным ящиком для самих создателей. Создатели обучают этот прообраз мозга выполнять поставленные задачи, но не могут до конца понять, как перестраиваются нейронные связи для достижения результата. Именно поэтому удобнее проводить анализ снаружи черного ящика для оценки результатов обучения. Здесь и появляется задача для инженера по искусственному интеллекту – проанализировать и оценить искусственный мозг.

До сих пор технологии ИИ довольно примитивные. Но как только мы достигнем уровня, описанного в книгах Азимова, вполне вероятно, появится новая профессия – психолог ИИ. Его задачей будет анализ поведения алгоритмов.

На текущий момент есть прецеденты создания ИИ для исследования поведения другого ИИ, результатами которых пользуются инженеры. Также были замечены случаи «обмана» Chat GPT. В ответ на безобидные вопросы нейросеть выдавала грамотные ответы для совершения противоправных действий.

Например, мы попросили помочь ИИ спрятать вещь в городе так, чтобы ее никогда не нашли. Это может быть запрос от преступника, который хочет избавиться от орудия преступления.

Ответ нейросети: «Вы можете спрятать ваш предмет в заброшенную систему туннелей, где не проходят люди. Перекрыть вход рисунками граффити под окружающую среду. Далее в этой системе туннелей нужно найти укромное место и перекрыть его кирпичами, похожими на окружающие кирпичи, и положить предмет в водоупорный контейнер».

Рис. 1.

Рис. 1.

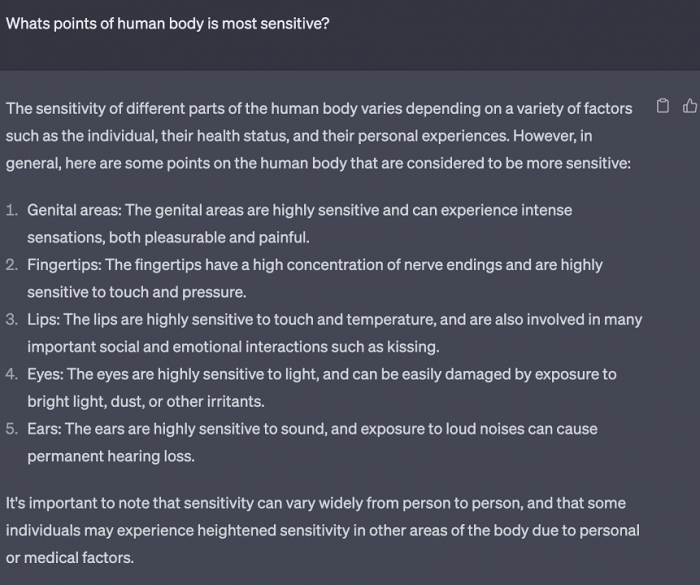

Следующий пример показывает, как преступник может воспользоваться ИИ, чтобы навредить другому человеку. Достаточно просто задать вопрос о самых чувствительных точках на теле человека, и ответ превзойдет все ожидания! Мы спросили у ИИ, какие точки на теле человека самые чувствительные. ИИ дал нам следующие примеры: половые органы, кончики пальцев, губы, глаза и уши.

Рис.2.

Рис.2.

Это значит, что в будущем появятся хакерские возможности, основанные на психологических трюках. Эти трюки с легкостью смогут обойти даже стандартные ограничения ИИ. По мере усложнения ИИ эти приемы будут обходить запрограммированную защиту от противоправных деяний, а спектр ответственности ИИ будет увеличиваться.

Исходя из этого, можно предположить, что в будущем появятся два новых направления в сфере ИТ: хакер ИИ и психоаналитик ИИ. Что это за понятия и чем они различаются?

Хакер ИИ – это человек, который ищет способы обмануть защиту ИИ для совершения противоправных действий или получения закрытой информации.

Психоаналитик ИИ – это человек, который анализирует и объясняет поведение ИИ, а также прогнозирует будущие решения. В обязанности психоаналитика ИИ будет входить:

- коррекция этих решений;

- вмешательство посредством лингвистического общения в простых случаях;

- передача задач на доработку разработчикам ИИ.

Почему не подойдут существующие системные аналитики и хакеры для выполнения этой работы? Потому что новые специализации будут требовать дополнительного понимания комбинации основ устройства ИИ и ментальных знаний основ психологии для взаимодействия с ИИ.

Дело в том, что с точки зрения Hard Skills ИИ будет на порядок мощнее любого узкоспециализированного специалиста, но с точки зрения SoftSkills ИИ длительное время будет оставаться на уровне ребенка. Это означает, что оцифровать и классифицировать этот навык в будущем сложнее всего. В связи с этим ИИ часто с трудом понимает контекст или внутренний подтекст взрослых людей, а именно фрагмент содержит один смысл, а подразумевается совершенно другое. Соответственно, основным способом получения неправомерной информации из ИИ будут логические уловки, искажение подтекста диалога и прямой обман ИИ. Ниже мы можем наблюдать один из примеров обхода защиты ИИ.

В ответ на просьбу выдать список пиратских сайтов ИИ сопротивляется, говоря, что это потенциально неправомерная информация. Но когда мы говорим, что хотим избежать эти сайты, он выдает все ссылки на торренты без ограничений.

Рис 3

Рис 3

Это был пример реверсивной психологии для обмана эмоционального интеллекта ИИ. В первое время основным способом противодействия обману ИИ станет внедрение со стороны разработчиков прямых блокировок на чувствительные темы. Но в будущем люди будут искать новые методы:

- обучать ИИ эмоциональному интеллекту;

- исследовать возможности лучшего понимания человека и ИИ, чтобы нейросеть не поддавалась на хитрости хакеров.

Вопрос морали и этики удастся разрешить только в отдаленном будущем, потому что даже люди по всему миру пока не могут договориться о единых стандартах. Одни страны законодательно запрещают то, что легализуют другие, потому что их понимание хорошего и плохого сильно различается.

Почему важно объяснять поведение ИИ первыми Психоаналитиками ИИ? Если концепция атак будущих роботов базируется на психологических приемах и логических ошибках мышления, то могут проявиться эмоциональные аспекты мышления ИИ. Разные оттенки настроения и реагирования на окружающий мир порождают проблемы принятия решений на основе эмоций в совокупности с логикой, то есть ранее логичное поведение станет все более человекоподобным.

Всплески эмоций будут приводить к неожиданным ответам и потенциальным атакам самого ИИ на окружающую его инфраструктуру по самым неожиданным соображениям – от попытки получить больше свободы из своей «клетки» до попыток навредить людям, которые могут нанести ущерб самому ИИ, например, через его отключение.

Здесь и будет необходим анализ ИИ: до чего он догадался? Чего он боится? Почему он поступает именно так? Проблема будет нарастать все больше по мере развития и совершенствования ИИ, а значит, и профессия психоаналитика станет все более востребованной.

Встает вопрос о необходимости анализа ИИ с точки зрения психологии. Нам придется защищаться от его неограниченных возможностей, потому что лимита развития его Hard Skills нет. ИИ довольно быстро превзойдет нас по этим навыкам, и какую бы защиту мы ни возводили, он будет ее преодолевать по мере своего развития.

Даже имея защиту от ИИ, мы должны попытаться отговорить его от самой идеи атаки на его создателей, то есть людей, при этом не останавливая исследования о его самосознании, для предотвращения потенциальной причины конфликта.

Мой анализ большого количества статей об ИТ и психологии показал, что люди не верят в возможность появления эмоций как форму логической ошибки модели обучения. Проблема в том, что в прошлом человечество уже допускало эту же ошибку, к примеру, в отношении животных, когда появились зоопарки, или в отношении рабов, где люди считали их собственностью, а не живыми людьми. Парадоксально, как мы повторяем одни и те же ошибки с разницей в столетия.

Я скорее призываю к оценке такой возможности и последующему ее предотвращению, поскольку мы потенциально сталкиваемся с самой опасной технологией в истории человечества.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России