Как искусственный интеллект генерирует изображения. Объясняет ML-инженер

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Диффузионные нейросетевые модели появились в 2015 году, но набрали популярность только в 2020 году после работы Ho et al. Сегодня они достигли результатов исключительного качества в большинстве задач генерации и изменения изображений, включая генерацию изображений по тексту (text-to-image), изменение стиля изображения (style transfer), изменение деталей изображения (inpainting) или повышение разрешения (super-resolution).

Генеративно-состязательные сети и их недостатки

Всего лишь несколько лет назад state-of-the-art-моделями в этих задачах считались генеративно-состязательные нейросети (generative adversarial networks или GAN), которые были предложены в 2014 году в работе Goodfellow et al и были значительно улучшены за прошедшие девять лет. Например, модель StyleGAN 3 2021 года в точности сохраняет детали лица даже при сдвигах и поворотах, тогда как ее предшественники генерируют в этом случае «шумные» детали — к примеру, волосы, бороды или узоры на одежде. Профессионалы и энтузиасты удивлялись, насколько хорошо GAN могут генерировать фотографии несуществующих людей, животных или квартир.

Тем не менее, из-за состязательного характера модели GAN очень нестабильны в обучении, также они показывают не очень большое разнообразие типов изображений при генерации. К тому же они слабо применимы в задаче генерации изображений по тексту, хотя примеры этого существуют.

Результаты генерации изображений моделью StyleGAN 3

Результаты генерации изображений моделью StyleGAN 3

Бум диффузионных моделей

Диффузионные модели, напротив, обладают достаточной вариативностью сгенерированных изображений и достаточно стабильны. Их главный минус — это скорость обучения и генерации. Для обучения модели необходимы десятки или даже сотни видеокарт, а генерация изображения при помощи уже обученной модели занимает несколько секунд, в отличие от GAN, где счет идет на десятки миллисекунд.

Результаты генерации из модели диффузии Ho et al

Результаты генерации из модели диффузии Ho et al

Бум вокруг моделей диффузии подогревается выходом больших генеративных моделей text-to-image. Наверняка многие читатели видели результаты, сгенерированные DALL·E 2, MidJourney, Imagen или Stable Diffusion. Некоторые художники и иллюстраторы переживают, что нейросети отберут у них работу, тогда как другие считают, что это только поможет в креативном процессе. Программисты и художники осваивают prompt engineering — искусство подбора текста для получения более точных результатов генерации, — и делятся интересными запросами и не менее интересными результатамиhttps://www.reddit.com/r/weirddalle.

Lofi alien invasion to relax and study to (нейросеть Midjourney)

Lofi alien invasion to relax and study to (нейросеть Midjourney)

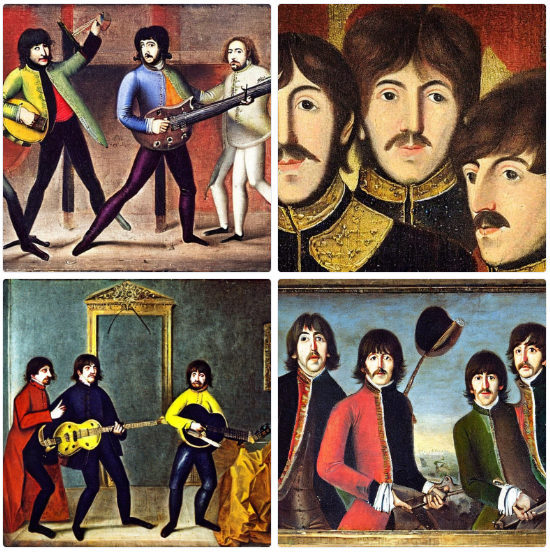

17th century painting of The Beatles (модель Stable Diffusion 2.1)

17th century painting of The Beatles (модель Stable Diffusion 2.1)

A dragon fruit wearing karate belt in the snow (модель Imagen)

A dragon fruit wearing karate belt in the snow (модель Imagen)

Как работают диффузионные модели?

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России