Разработан инструмент, позволяющий художникам «отравлять» свой контент для ИИ

Друзья, с момента основания проекта прошло уже 20 лет и мы рады сообщать вам, что сайт, наконец, переехали на новую платформу.

Какое-то время продолжим трудится на общее благо по адресу

На новой платформе мы уделили особое внимание удобству поиска материалов.

Особенно рекомендуем познакомиться с работой рубрикатора.

Спасибо, ждём вас на N-N-N.ru

Блог компании FirstVDS. Автор: @virtual_explorer. С тех пор, как год назад вышел ChatGPT, индустрия генерации цифрового контента находится в суматохе. Всех постепенно начинает вытеснять ИИ. Ряд художников, авторов, исполнителей, и даже звукозаписывающие компании подали многочисленные иски против компаний, занимающихся искусственным интеллектом, в основном против OpenAI. Все они касаются одного: обучающих данных.

Компании ходят по всему интернету и собирают миллиарды фрагментов текста/звука, а также миллионы изображений в дата-сеты для тренировки своих моделей ИИ. Естественно, авторам или владельцам контента за это никто не платит, и их даже вообще никак не нотифицируют. Развитие технологии превыше всего.

Чтобы пресечь такой сбор данных, Reddit и X этим летом запретили доступ к своим API сторонним приложениям. Но обычные дизайнеры и цифровые художники не имели никакой возможности противостоять использованию их работ для обучения новых коммерческих ИИ.

При этом практику свободного распространения данных в интернете художники обычно поддерживают. Индексация их картинок раньше могла принести новых клиентов или сделать популярнее их сайт. Но теперь многие вынуждены делать свои данные полностью приватными, опасаясь со временем остаться вообще без работы. Чем больше картинок о тебе есть в Сети — тем точнее твой стиль может скопировать одна из этих моделей. Дошло до того, что если ты популярен, сейчас можно дать боту команду «сделай мне эту картинку, но в стиле художника Х». Вместо того, чтобы платить сотни долларов и ждать результата неделю, картинка выходит бесплатно и через несколько минут. Кому-то такая «демократизация контента» очень нравится, но сами создатели цифровых изображений от этого развития в шоке.

Теперь же у художников появился шанс дать реальный отпор ИИ. Чтобы не они боялись генеративных моделей, а те боялись их. Это будет сделано не с помощью эфемерных судебных исков, а тоже с помощью передовых технологий. Недавно MIT Technology Review получили эксклюзивный доступ к новому инструменту с открытым исходным кодом под названием Nightshade, который художники смогут добавлять к своим изображениям перед их загрузкой в Сеть. Он изменяет пиксели способом, невидимым для человеческого глаза, но это «отравляет» картинку для любых моделей ИИ, желающих на ней тренироваться. Технология готовится к выпуску, будет доступна бесплатно для всех, и, похоже, имеет хорошие шансы изменить всю индустрию.

Откуда взялся Nightshade

Nightshade был разработан исследователями Чикагского университета под руководством профессора информатики Бена Чжао. Он будет добавлен в качестве дополнительной настройки к их предыдущему продукту Glaze, еще одному онлайн-инструменту, который может скрывать цифровые произведения искусства и изменять их пиксели, чтобы сбить с толку модели ИИ относительно их конкретного стиля.

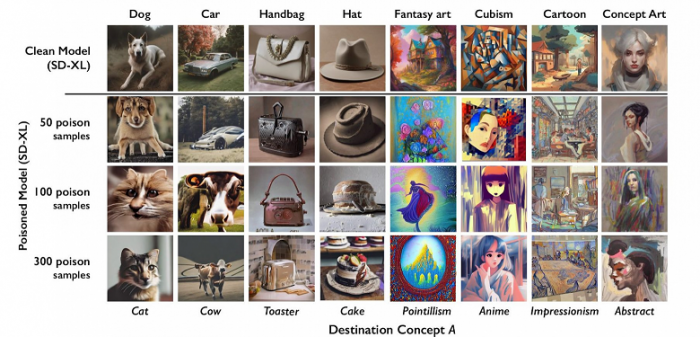

В случае с Nightshade технология противодействия ИИ идет намного дальше: система даже заставляет модели ИИ запоминать неправильные названия объектов и пейзажей, на которые они смотрят. В качестве примера исследователи отравили изображения собак, включив в пиксели информацию, благодаря которой для моделей ИИ они выглядели как кошки. Постепенно при запросе «нарисуй мне собаку» генеративная модель могла выдавать только что-то кошкоподобное.

Работа Nightshade: если смотреть сверху вниз, картинки постепенно ухудшаются, потому что датасет «отравляется» всё большим количеством «токсичных» изображений

Работа Nightshade: если смотреть сверху вниз, картинки постепенно ухудшаются, потому что датасет «отравляется» всё большим количеством «токсичных» изображений

Грубо говоря, у ИИ получается «замутнение разума», и оно не понимает, что именно находится перед ним, и как это использовать. Машины превращаются в коров, сумочки — в тостеры, реалистичный стиль — в какую-то абстракцию. Поскольку каждый художник может внедрить свою информацию, противодействия такой системе (по крайней мере, теоретически) нет. Единственный вариант для создателей ИИ — обходить картинки такого иллюстратора стороной, чтобы он не портил им обучение.

При этом заметьте, что самая отвратительная мешанина получается, когда «отравленных» изображений в датасете немного. Если они начинают доминировать — модель с большой четкостью рисует кошку. Но если таких картинок немного, выходит ужасный котопес, которого точно не захочет увидеть ни создатель, ни пользователь ИИ. Поэтому даже относительно небольшое количество изображений, «испорченных» с Nightshade, может сильно усложнить разработку новых генеративных моделей.

Конечно, обычных картинок в интернете всегда будет больше. Поэтому даже в мире с Nightshade GPT-ИИ не станут выдавать «кошек». Но они будет работать сильно хуже. Может даже оказаться, что самые точные генеративные ИИ были выпущены до того, как были найдены способы им противодействовать.

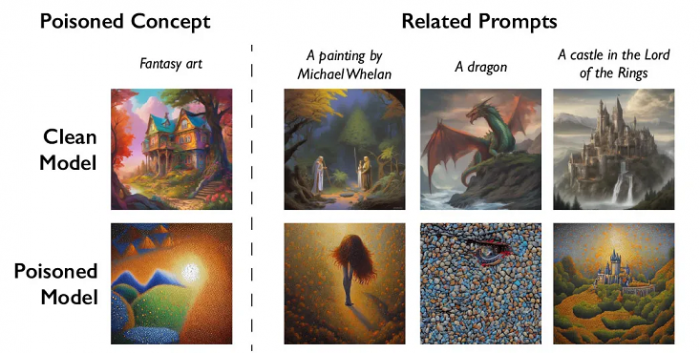

Яд капает с клыков

Для тестирования Nightshade и получения фото исследователи применяли Stable Diffusion. Благодаря характеру работы генеративных ИИ — путем группировки концептуально схожих слов и идей в пространственные кластеры, известные как embeddings — Stable Diffusion также перестала нормально работать на словах «хаски», «щенок» и «волк». По всем этим запросам модель теперь тоже выдавала что-то похожее на кошек.

По словам разработчиков, от техники отравления данных крайне сложно защититься, поскольку она требует от разработчиков ИИ-моделей отсеивать любые изображения, содержащие зараженные пиксели. Но многие обычные картинки тоже имеют ошибки и погрешности. Отличить их от технологии Nightshade будет крайне непросто.

Обычная генерация изображений (сверху), генерация в отравленной модели (снизу)

Обычная генерация изображений (сверху), генерация в отравленной модели (снизу)

Любые зараженные изображения, которые уже были добавлены в набор обучающих данных, также придется как-то обнаруживать и удалять. Если какие-то пройдут через фильтр, выяснить это можно будет только после дорогого и длительного процесса обучения модели. А если модель ИИ уже была на них обучена, её, скорее всего, придется переобучать.

Вместо этого, возможно, проще будет заплатить создателям картинок за исходные изображения, которые не были «заражены» технологией Nightshade. И таким образом художники сохранят права на свою интеллектуальную собственность. А те, кто просто хочет загружать фото своих собак и котов в Интернет, даже не будут знать о той борьбе, которая идет за кулисами.

- Источник(и):

- Войдите на сайт для отправки комментариев

Сайт о нанотехнологиях #1 в России

Сайт о нанотехнологиях #1 в России